生成式 AI(Generative AI)是一種使用人工智慧來創造內容的技術,它可以用於生成各種內容,包括文章、圖像、音樂和影片。生成式 AI 通過學習大量的數據來進行訓練,這些數據來源廣泛,包括書籍、文章、網站或其他公開資源等。所以,網站已公開的內容自然也成為訓練數據的重要來源。但不是每個網站都願意成為生成式 AI的訓練教材,至於要如何規範?以 OpenAI 的 ChatGPT 為例,已率先規範自家「GPTBot」爬蟲須遵守 robots.txt 檔案內的指示存取網站內容,換句話說,網站所有人可以自行決定網站內容要不要提供給 ChatGPT 使用。

robots.txt 是一種存放於網站根目錄下的文字檔案,主要用來告訴網路搜尋引擎的爬蟲,網站中的哪些內容是不應該或可以被搜尋引擎的漫遊器取得的。OpenAI 除了要自家「GPTBot」爬蟲機器人遵守 robots.txt 的指示外,還提供 ChatGPT-User 爬蟲,而這兩個爬蟲主要的不同點是在 GPTBot 為自動執行,而 ChatGPT-User 則用於插件屬被動式,僅代為 ChatGPT 的用戶執行操作。另外,OpenAI 也公布爬蟲所使用的 IP 區段,讓網站主除了可以使用 robots.txt 文件指引爬蟲外,也能有更釜底抽薪的辦法,那就是直接在伺服器直接禁止某些 IP 存取內容。

搜尋引擎與生成式 AI 這兩類的爬蟲所爬取的數據範圍可能有所不同,搜尋引擎是為內容建立索引,方便用戶搜尋,另一個則是為取得訓練數據藉以產生結果,當然,我們樂見 OpenAI 利用 robots.txt 文件規範自家爬蟲,儘管此類協議並無強制性,OpenAI 會遵守,但並不代表所有類似的網路爬蟲都能遵守。

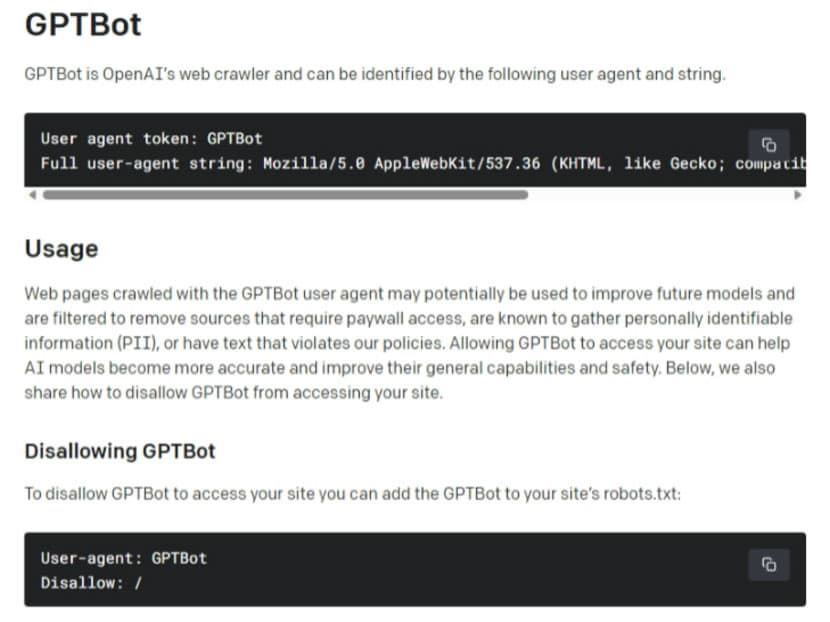

GPTBot

按照 OpenAI 說明文件的說明,GPTBot 是 OpenAI 的網絡爬蟲,在網站伺服器可以透過以下的 User Agent 和字串來識別。

User agent token: GPTBot

Full user-agent string: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.0; +https://openai.com/gptbot)

當然 OpenAI 會希望讓 GPTBot 訪問自己的站點,以協助 AI 模型變得更加準確並提高其總體功能和安全性。但還是提供如何禁止 GPTBot 訪問您的網站的方法。

禁止 GPTBot

要禁止 GPTBot 訪問自己的網站,可以將以下內容加入 robots.txt:

User-agent: GPTBot

Disallow: /

設定 GPTBot 可存取的路徑

可以根據實際狀況修改以下的範例:

User-agent: GPTBot

Allow: /directory-1/

Disallow: /directory-2/

除了使用 robots.txt 指示詞外,還可以使用 OpenAI 所公布的 GPTBot 所使用的 IP 網段,直接在網站伺服器內阻擋這些 IP 位址(取得最新 IP 網段)來防止 ChatGPT 存取網站內容。

IP egress ranges:

20.15.240.64/28

20.15.240.80/28

20.15.240.96/28

20.15.240.176/28

20.15.241.0/28

20.15.242.128/28

20.15.242.144/28

20.15.242.192/28

40.83.2.64/28

OpenAI 除了有主動出擊的「GPTBot」爬蟲外,還有代用戶執行的「ChatGPT-User」,主要用於外掛插件,僅接受用戶的指揮。

ChatGPT-User

User agent token: ChatGPT-User

Full user-agent string: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; ChatGPT-User/1.0; +https://openai.com/bot

允許 ChatGPT-User

可以將 ChatGPT-User 加入 robots.txt:

User-agent: ChatGPT-User

Disallow:

禁止 ChatGPT-User

可以將 ChatGPT-User 加入 robots.txt:

User-agent: ChatGPT-User

Disallow: /

設定 ChatGPT-User 可存取的路徑

可以根據實際狀況修改以下的範例:

User-agent: ChatGPT-User

Disallow:

Allow: /directory-1/

Allow: /directory-2/

除了使用 robots.txt 指示詞外,還可以使用 OpenAI 所公布的專用網頁瀏覽插件的 ChatGPT-User 所使用的 IP,直接在網站伺服器內阻擋這些 IP 位址。

IP egress ranges:

23.98.142.176/28

總結來說,OpenAI 在保護隱私與智慧財產權方面率先採取行動。OpenAI 通過「GPTBot」和「ChatGPT-User」爬蟲的設計,確保它們遵守 robots.txt 協議,同時公開了這些爬蟲所使用的 IP 區段。這樣一來,網站管理者能夠根據自己的需求,自主地決定是完全禁止存取網站內容,還是開放部分或全部內容。

儘管 robots.txt 協議並不具有強制執行力,然而 OpenAI 作為生成式 AI 技術的領先者,以實際行動展現了保護使用者隱私和維護智慧財產權的承諾。這不僅為行業設定了良好的標準,也逐漸鞏固了 OpenAI 在領域中的領導地位。